下载ollama

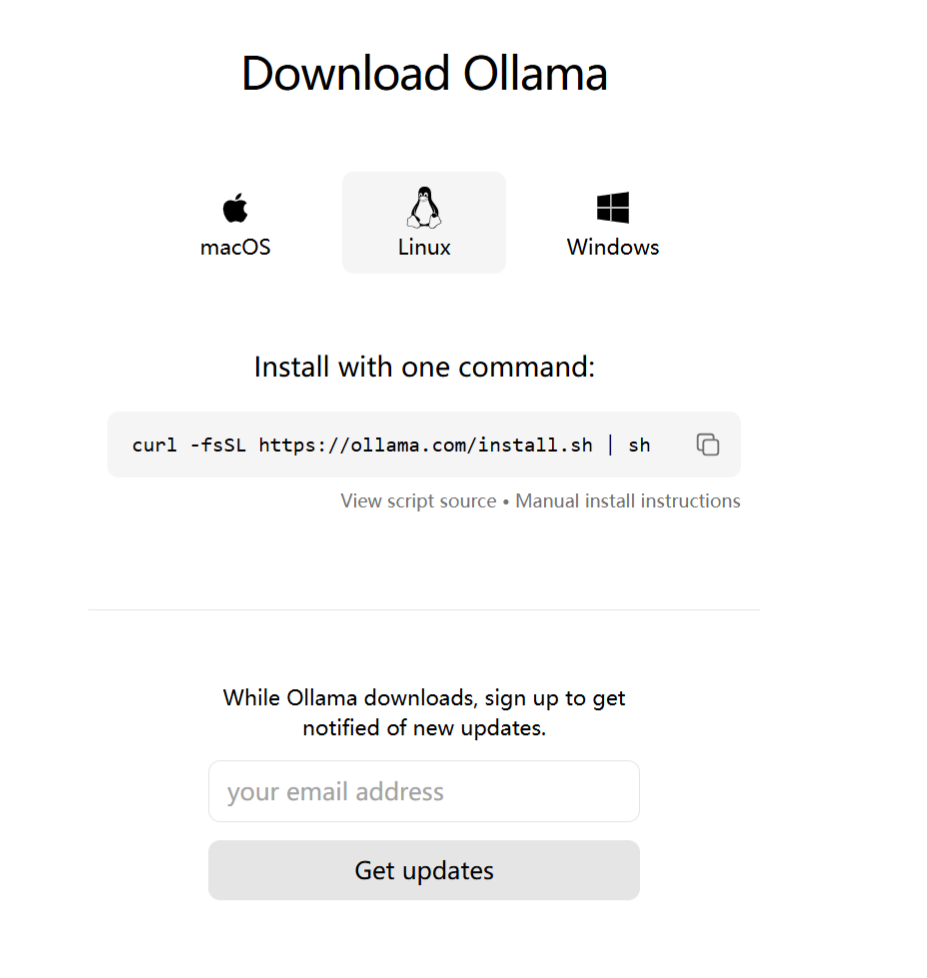

Ollama官网 在官网按照自己的系统下载对应的ollama文件

在ubuntu中执行命令即可

1 | curl -fsSL https://ollama.com/install.sh | sh |

等待下载完成。

如果下载速度缓慢可以使用修改终端代理的方式进行加速

在终端中执行以下命令

1 | #7890 为代理端口,我使用的是clash,默认是7890 |

重新执行下载命令

1 | curl -fsSL https://ollama.com/install.sh | sh |

如果不想修改模型存储的位置,则可以直接执行下载模型命令即可

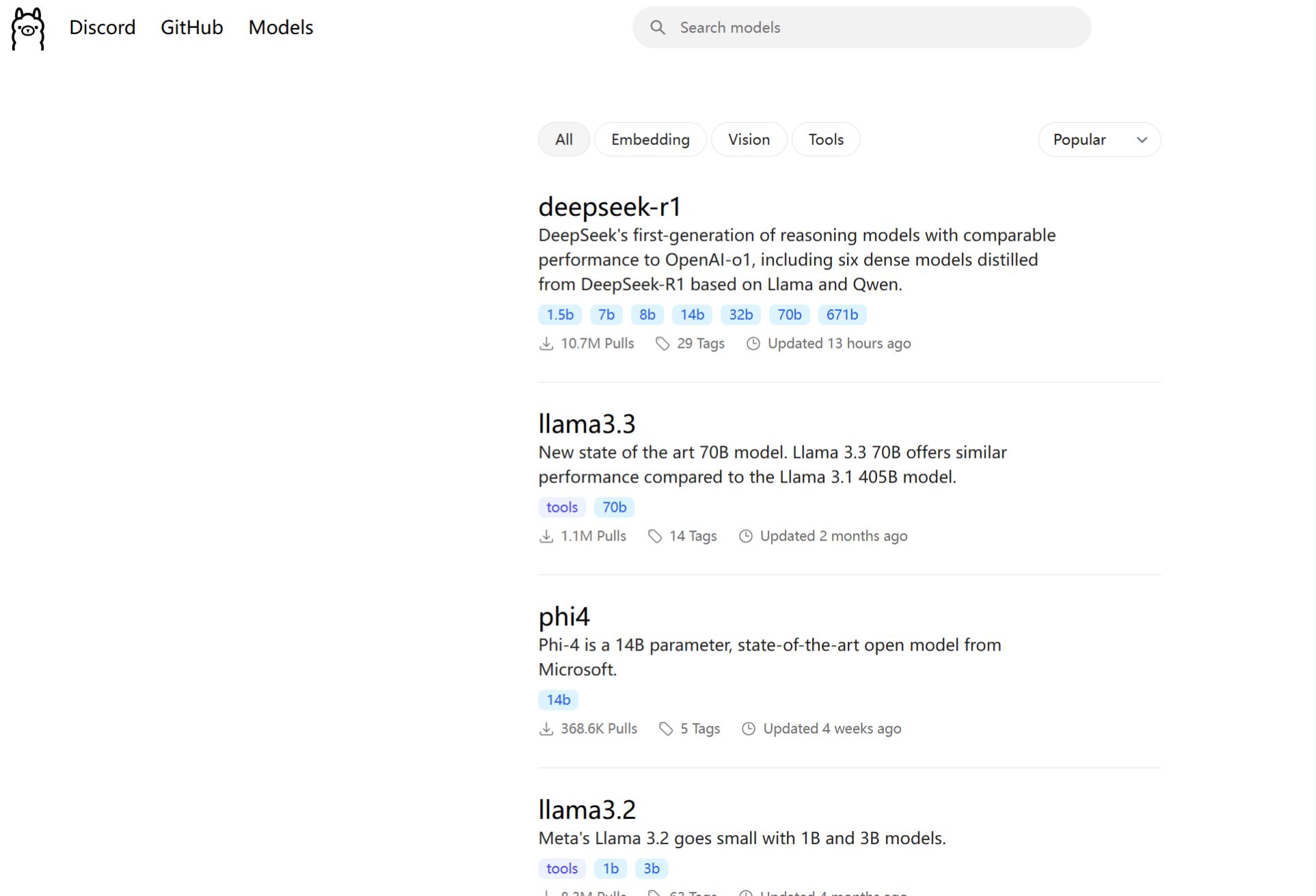

下面以deepseek为例

1 | ollama run deepseek-r1 |

ollama支持很多模型,具体可以到它的官网去看看

models

由于有些模型动辄几百G,所以更换路径很有必要

修改模型位置

默认的模型存放在/usr/share/ollama/.ollama/models

- 修改ollama配置文件添加内容

1

sudo vim /etc/systemd/system/ollama.service

OLLAMA_MODELS 为模型路径

OLLAMA_HOST 为解析的地址1

2

3Environment="OLLAMA_MODELS=/mnt/hdd/ollama/models"

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_ORIGINS=*" - 保存退出,重启ollama服务

1

2sudo systemctl daemon-reload

sudo systemctl restart ollama - 查看ollama状态systemctl status ollama`:检查 Ollama 服务的状态,确保其正常运行。

1

sudo systemctl status ollama

- 查看本地模型

1

ollama list

使用open-webui访问deekseek

参考:

ollama-ui/ollama-ui: Simple HTML UI for Ollama

利用 Open-WebUI + Ollama 部署属于我们自己的大模型平台 引言 Open WebUI是一个可扩展、功 - 掘金

- 拉取 Open WebUI 镜像

1

docker pull ghcr.io/open-webui/open-webui:main

- 启动 Open WebUI 容器

先创建一个用于 Open WebUI 容器本地存储的本地目录通过以下命令启动容器, 映射本地3000 端口号, 并挂载本地目录 /opt/openwebui 到容器的 /app/backend/data1

mkdir /opt/openwebui

1

sudo docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v /opt/openwebui:/app/backend/data --name openwebui --restart always ghcr.io/open-webui/open-webui:main

Open WebUI 容器启动完成后,就可以在浏览器中输入 http://{主机IP}:3000 访问 Open WebUI

- 感谢您的赞赏

赞赏名单

由于您的支持,我才能够实现写作的价值。

本文是原创文章,采用CC BY-NC-SA 4.0协议,完整转载请注明来自我的笔记